Motivation und Problemstellung

Elektronische Augen und künstlicher Verstand erlauben bereits heute Erkennungsleistungen wie z.B. automatische Türwächter, Fahrassistenzsysteme und befähigte Wohnräume, die über das Wohl ihrer Bewohner wachen. Dabei wird die Privatsphäre der Menschen gewahrt, indem die Videodaten direkt im Sensor verarbeitet werden („eingebettete KI“). Diesem neuen Nutzen stehen aber auch Aufwände gegenüber, welche die weite Verbreitung noch behindern. Insbesondere die Erkennung zeitlich zusammenhängender Aktivitäten und Vorgänge stellen eine große Herausforderung dar.

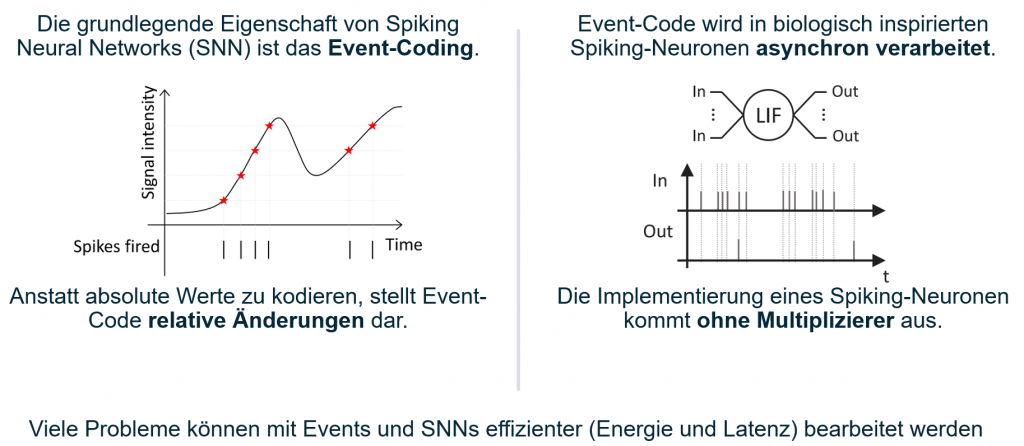

Vor allem komplexe Anwendungen mit konventioneller KI (künstliche neuronale Netze, z.B. Convolutional Neural Networks – CNNs, Recurrent Neural Networks – RNNs, etc.) haben einen Bedarf an Rechenleistung, der in eingebetteten Hardware-Lösungen einen zu hohen Stromverbrauch, Probleme mit der Abwärme und hohen Herstellungskosten verursacht. Eine Echtzeitverarbeitung in Anwendungen zur Erkennung von Aktivitäten mit zeitlichem Kontext ist daher in vielen Fällen nicht mit eingebetteter KI leistbar.

Zielsetzung

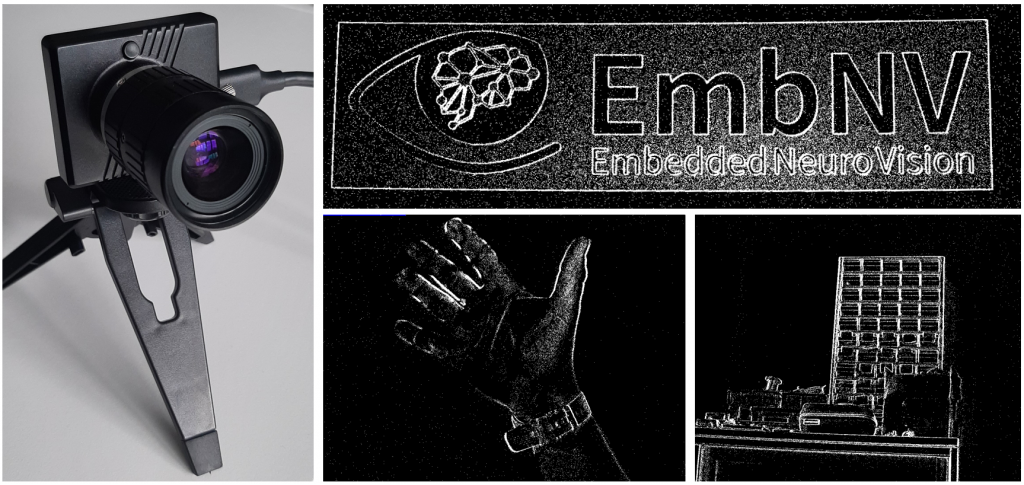

Als Lösung können anstatt klassischer Kameras sog. Event-basierte Kameras (engl. Event Based Camera, EBC) verwendet werden, welche nur Änderungen über die Zeit als kontinuierlichen Datenstrom ausgeben. Durch dieses Funktionsprinzip entsteht bei solchen EBCs eine inhärente Filterung des beobachteten Bereichs, wobei “Uninteressantes” ignoriert wird und nur sich ändernde Bildbereiche ausgegeben werden, was eben die Bereiche mit Aktivitäten sind. Abseits des Umstands, dass solche EBCs alleine schon weniger Energie benötigen als ihre klassischen Gegenstücke, wird durch diese Filterung auch die Menge an Daten reduziert, die ein nachfolgender KI-Algorithmus verarbeiten muss. Das Ziel dieses Vorhabens ist es daher, zu untersuchen, wie solche Event-basierten Kameras in ein bestehendes Bildverarbeitungssystem integriert werden können, welche Systemkomponenten hierfür angepasst werden müssen und welche Vorteile der Einsatz einer EBC tatsächlich bringt.

Als Anwendung wird das Produkt PatronuSens® der Inferics GmbH betrachtet, welches kritische Situationen wie etwa Bewegungslosigkeit, Inaktivität und Stürze in Wohnräumen erkennt und im Notfall mit einer Alarmnachricht an Pflegekräfte oder Angehörige reagieren kann. Hierfür verwendet PatronuSens aktuell eine klassische Kamera, welche im Rahmen des Vorhabens durch eine EBC ersetzt werden soll.

Im Erfolgsfall wird dadurch ein mobiles, energiesparendes System ermöglicht, welches eine Tür für breite Märkte öffnet.

Erwartbare Wertschöpfungspotenziale und Nutzen für KMUs

Als Wertschöpfungspotentiale für die Vorhabensergebnisse kommen die Potentiale aller Systeme in Betracht, welche die Erkennung von Bewegungs-Aktivitäten (von Personen und Objekten) für ihre Systemleistung als eingebettete Komponente integrieren müssen. Der bestehende Hemmschuh in Form zu hoher, erforderlicher KI-Rechenleistung kann durch die Ansätze des Vorhabens überwunden werden. In der Haus-Automatisierung kann die Aktivitätserkennung als Erweiterung einer „Alexa“ gedacht werden, welche dann auch Gesten erkennt und z.B. beim nächtlichen Aufstehen das Licht einschaltet. Im pflegerischen Bereich kann der Bedarf an kostengünstiger Notfallprävention gedeckt werden und die Pflegedokumentation teilweise automatisiert werden. Maschinen und Roboter können mit einer integrierten Personen-Aktivitätserkennung sicher, zielgerichtet und flexibel mit Menschen kooperieren. Zunächst sollen jedoch die Potentiale im „Heimfeld“ des Produkts PatronuSens der Inferics GmbH erschlossen werden, der Pflege. Dies wird im Kapitel „Ergebnisverbreitung (Verwertungsplan)” vertieft.

Ergebnisse

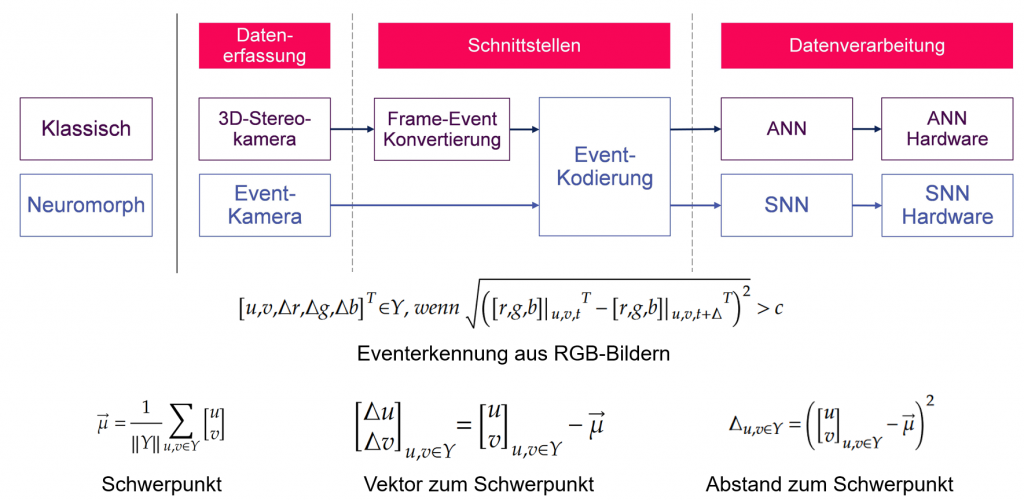

Im Laufe des Projekts wurden „Event-basierte“ Kameras parallel zu klassischen „Frame-basierten“ Kameras eingesetzt, um einen Datensatz mit zwölf verschiedenen Gesten/Aktionen zu erstellen. Dieser Datensatz wurde verwendet, um sowohl klassische neuronale Netze (CNN+LSTM) als auch Spiking Neural Networks darauf zu trainieren, die gezeigten Gesten zu klassifizieren. Die so trainierten Netze wurden auf entsprechenden Hardware-Beschleunigern ausgeführt und die beiden resultierenden Systeme (klassisch und Event-basiert) hinsichtlich der Vorhersagegenauigkeit, elektrischen Leistungsaufnahme und erzeugten Datenrate verglichen. Das Event-basierte System erreichte dabei bei wesentlich geringerer Datenrate und el. Leistungsaufnahme eine höhere Vorhersagegenauigkeit. Die Abbildung zeigt einen Ausschnitt des Demonstrationssystems. Details zur Projektdurchführung und den Ergebnissen können dem Abschlussbericht entnommen werden.